湖南科技大学信息与电气工程学院 湘潭 411201

摘要:随着深度学习的快速发展,各个领域的算法取得了重大突破,Transformer在超分辨率领域中被广泛使用。因此本文应用了注意力机制的Transformer进行超分辨率任务,主要介绍了超分辨率的基本构造和性能指标。

关键词:超分辨率,注意力,Transformer

通信作者:胡仕刚(1980.9-),男,湖北咸宁,教授,从事信号与信息处理研究与教学。

1引言

图像超分辨率(SR)是一项传统的低水平视觉任务,主要是从低分辨率(LR)对应图像中恢复高分辨率(HR)图像。基于深度卷积神经网络(CNN)的方法在图像SR领域表现出显著的功效。然而,卷积采用了局部机制,阻碍了全局依赖关系的建立,限制了模型的性能,因此很难有效地在空间和信道维度上建模全局依赖关系。

Transformer模型最初是用于自然语言处理领域,但近年来被成功地应用于计算机视觉任务。在超分辨率处理中,Transformer模型能够更好地捕捉图像中的长距离依赖关系,并且能够更好地处理图像中的细节和纹理,随着深度学习的不断发展,相信基于Transformer的超分辨率网络将会在图像处理领域发挥越来越重要的作用。

2结构与方法分析

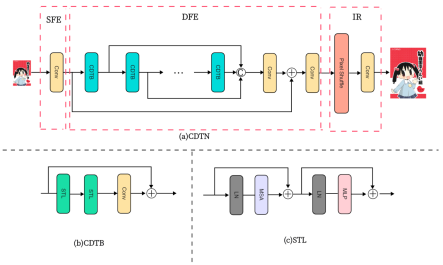

本文详细描述了超分辨率的主要实现流程,从SFE( Shallow Feature Extraction,浅层特征提取)、DFE(Deep Feature Extraction,深层特征提取)到IR(Image Reconstruction,图像重建),复现了低分辨率图像重建到高分辨率图像的详细过程。

1)浅层特征提取

在超分辨率图像处理中,SFE通常使用3×3Conv提取图像的低级特征,比如边缘、纹理等。通过提取这些特征,可以帮助提高图像的分辨率,并使图像更加清晰。通过提取浅层特征,超分辨率图像处理可以更好地保留图像的细节和纹理信息。

2)深层特征提取

深层特征通常指的是图像的高级语义特征,比如物体的形状、结构等。通过提取这些特征,可以帮助提高图像的分辨率和具有更好的语义信息,从而提高图像的清晰度和质量。

(1)注意力机制[1]:区分图像输入中不同部分的重要程度,从而能够更好地捕捉关键信息。典型的注意力机制主要有CA(Channel attention),SA(Spatial attention)等,本文使用MSA(Multi-head Self-Attention,多头注意力)。

(2)前馈网络:前馈网络可以通过学习输入数据的特征表示,这种特征表示可以用于后续的数据分析和处理任务。本文中使用经典的MLP(多层感知机)结构,它是一种最基本的前馈神经网络模型,由一个或多个全连接层组成,每个全连接层由多个神经元组成,每个神经元与上一层的所有神经元相连。

(3)归一化:归一化是一种数据预处理技术,它将数据转换为特定范围内的统一分布,归一化使得数据更易于比较和分析。典型的归一化有LN(Layer Normalization,层归一化),BN(Batch Normalization,批量归一化)。本文使用LN可以缓解梯度消失问题、提高网络训练速度、提高模型的泛化能力,以及降低对初始参数的敏感性。

(4)Transformer:Transformer能够更好地捕捉图像中的长距离依赖关系,并且能够更好地处理图像中的细节和纹理。如图1(c)所示中的STL(Swin Transformer Layer)[2]是典型的Transformer结构。

(5)CDTB(CNN and Double Transformer Blocks):CDTB作为本文的基础模块,如图1(b)所示,由两个STL和一个3×3Conv串联再通过残差连接组合而成。

在DFE中以CDTB为基础模块进行特征提取,并且引入残差连接,残差连接有助于提高网络的性能。通过引入残差连接,通过残差连接,网络可以更好地处理梯度的传播。

3)图像重建

将低分辨率的图像放大到原始分辨率的过程,常见的方法有双线性插值、最近邻插值、反卷积等。本文使用的方法是亚像素卷积,可以帮助网络更好地理解和处理图像的细节,学习到更加精细的特征。

4)性能指标

超分辨率的性能指标有:

峰值信噪比(PSNR):PSNR是评估图像质量

图 1基于Transformer的超分辨率网络

的常用指标,PSNR的数值越高,表示重建图像质量越好。

结构相似性指标(SSIM)[3]:SSIM是另一个常用的图像质量评估指标,它考虑了亮度、对比度和结构三个方面的相似性。与PSNR不同,SSIM能更好地反映人眼对图像质量的感知。

指标可以帮助评估超分辨率算法在重建图像时的性能,但要注意的是,单一指标可能无法全面反映图像质量,因此通常会综合考虑两个指标来评估算法的性能。

3总结

本文利用Transformer结构复现了超分辨率的基本过程,图1(a)CDTN用一个3×3Conv卷积层进行浅层特征提取,总共使用了12个DCTB模块和残差结构进行深层特征提取,在图像重建阶段使用亚像素卷积层。本文主要是介绍了超分辨率的流程,在结构和性能方面,仍有一些能进一步改进的

方面:

(1)注意力机制:注意力机制也在不断的创新和改进,可以使用另外的注意力机制来替换,用来改进模型的性能。

(2)前馈网络:虽然MLP是一种经典的神经网络模型,但它也存在一些局限性,对于复杂的非线性模式的学习能力有限。随着卷积的不断创新,前馈网络的潜在性能也在被挖掘。

参考文献

[1]Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[J]. Advances in neural information processing systems, 2017, 30.

[2]Liang J, Cao J, Sun G, et al. Swinir: Image restoration using swin transformer[C]//Proceedings of the IEEE/CVF international conference on computer vision. 2021: 1833-1844.

[3]Z. Wang, A.C. Bovik, H.R. Sheikh, E.P. Simoncelli, Image quality assessment:from error visibility to structural similarity, IEEE Trans. Image Process. 13 (4) (2004) 600–612.